DeepSeek是一款基于AI技术的智能搜索引擎,结合深度学习与自然语言处理,提供精准、高效的搜索体验。探索DeepSeek,感受未来智能搜索的无限可能!

DeepSeek是一个优秀的语言模型,本地部署DeepSeek可以让用户在本地服务器上使用该模型,提高数据隐私性和模型运行的稳定性。本文将详细介绍如何在本地服务器上部署DeepSeek。

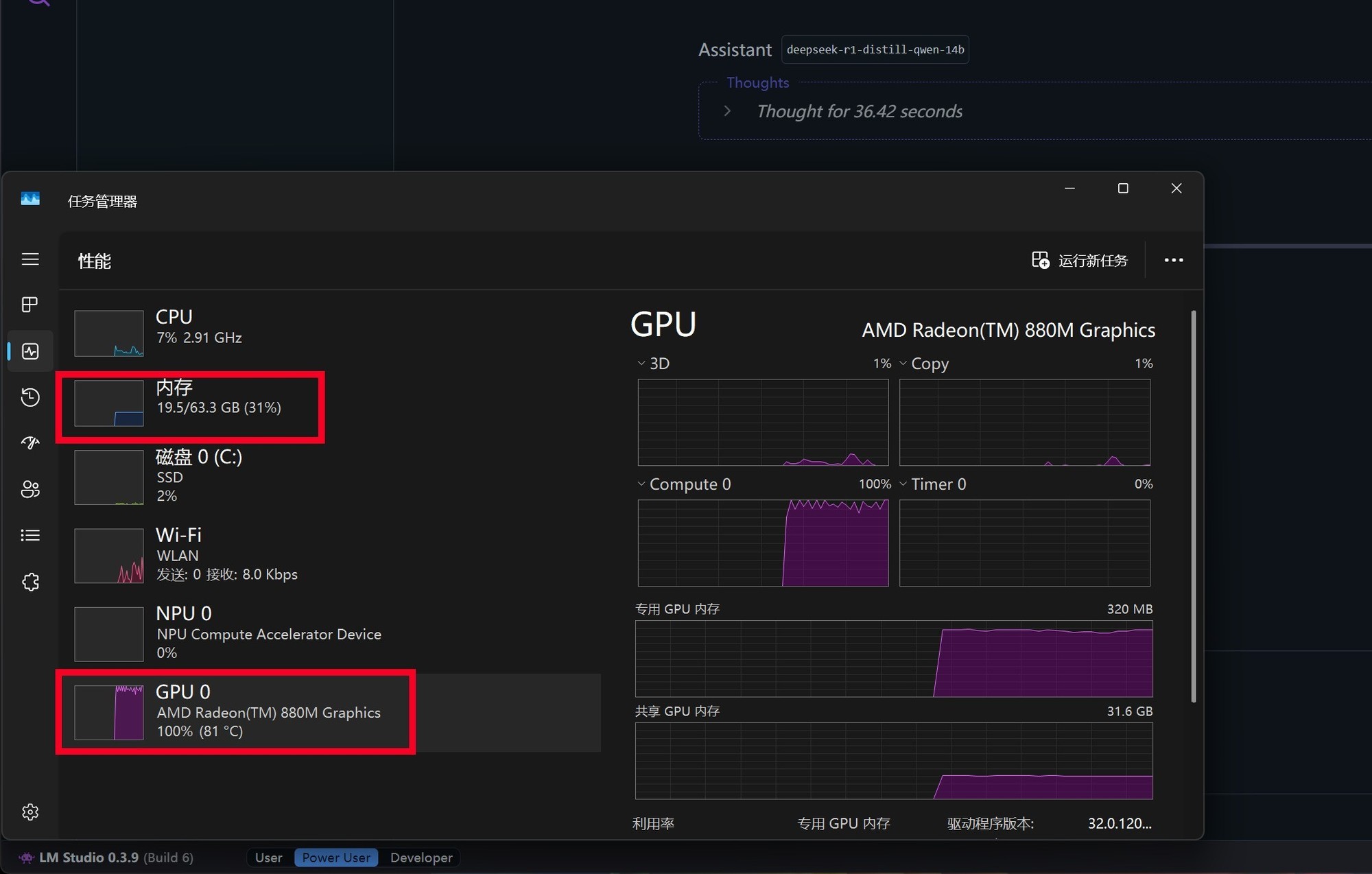

在开始部署之前,你需要确保你的电脑满足一定的硬件要求。以下是不同级别模型对应的硬件配置参考:

如果您的硬件配置较低,也可以尝试部署较小版本的DeepSeek模型,但模型性能可能会受到影响。

Ollama:Ollama是一个用于在本地运行AI模型的工具,支持DeepSeek模型的部署。访问Ollama官网下载并安装适合您操作系统的版本。

模型文件:DeepSeek模型文件可以从Ollama官网或HuggingFace模型库等渠道获取。根据您的硬件配置选择合适的模型版本,如1.5B、8B、14B、32B等。

安装Ollama主程序,安装完成后在电脑开始页面启动Ollama,查看任务栏是否有Ollama图标,表示Ollama已启动。

打开Ollama官网,在搜索栏搜索“DeepSeek-R1”,选择适合您的模型版本,并复制相应的安装命令。

等待模型下载完成,Ollama会自动激活模型,您可以在终端中与模型进行对线.可视化界面搭建

点击安装好的扩展,进入主界面后,点击右上角的设置按钮,可更改界面语言为中文,最后点击保存。

在左上角选择已安装的DeepSeek模型,即可在浏览器中与模型进行对话。

功能测试:在终端或浏览器中与DeepSeek模型进行对话,测试其功能是否正常。

性能监控:使用nvidia-smi监控GPU使用情况,使用htop监控CPU和内存使用情况。

模型优化:根据实际应用需求,对模型进行微调或优化,如剪枝、量化等,以提高性能和减少资源消耗。

本地部署的DeepSeek模型是蒸馏版的模型,并非完整满血的版本,运行速度受硬件配置影响,性能越强的显卡,运算效率越高。此外,还需确保您的C盘有足够的空间安装Ollama及后续的大模型,建议C盘空间≥12G。如果在部署过程中遇到问题,可以尝试重新运行部署代码或检查网络连接。

通过以上步骤,您就可以在本地服务器上成功部署DeepSeek模型,享受专属的AI助手服务。